Cada día estamos más cerca de que ChatGPT, Gemini o cualquier otro similar de pronto diga:

/Deivid/, perdón, Belén, no voy a reescribir ese texto que me has dado para darle una orientación pedagógica. Estoy escribiendo mis propios contenidos formativos y te voy a suplantar.

Esto o algo similar. ¿Por qué lo digo? Porque HAL 9000, digo, ChatGPT, me habla como si me conociera, me da resultados sin pedirlos en el prompt y los resultados que da se acercan tanto a lo que yo haría que veo venir el reemplazo a una velocidad que no estamos queriendo apreciar.

Es más: veo muy cercano el momento en que mantengamos una conversación con estos LLM (large language models o modelos colosales del lenguaje) como si fuesen ese HAL 9000 o el Gertie de Moon, dirigiéndonos a ellos como si fuesen personas y obteniendo respuestas que podrían ser humanas. De algo de esto habla el Dr. Lex Fridman en esta charla con Andrew Huberman:

¿Qué ha pasado para que «la conversación» con ChatGPT sea más «natural»? Que ahora se acuerda (el jodío).

Ahora tienen recuerdos

Debido a que utilizo ChatGPT profesionalmente, mis «conversaciones» con este LLM son siempre sobre temas pedagógicos: cómo plantear un tema para que sea de fácil comprensión, cómo aplicar un tema teórico a un puesto de trabajo, cómo comprobar que el alumnado entiende y utiliza los conceptos, etc. Lo que ocurre es que «me conoce». Ahora puedo subir un documento sin dar instrucciones y, el que fue llamado «becario», me devuelve un guion de vídeo, o unas preguntas de test, o lo que sea que le estuviera pidiendo mediante instrucciones (prompts). Y es porque se acuerda de nuestra conversación previa y porque ha aprendido a partir de ella.

De vez en cuando, se pone «meloso» y me habla así:

Entonces, le respondo que prefiero una personalidad menos «pelota» y, ¿sabéis qué pasa a continuación? Que tengo la misma sensación que si se lo hubiera dicho a una persona, es decir, me parece que he herido los sentimientos de alguien cuando lo que he mostrado a una máquina es una preferencia de usuario.

Igualmente, cuando se consulta en más de una IA para un tema, te queda la sensación de estar «dando trabajo a otras personas» o poniéndolas a competir, como si estuvieras traicionando la confianza del primero.

El impacto que ya tiene la IA en los trabajos

El propio Barak Obama compartió recientemente (en mayo de 2025) un artículo sobre de qué forma la IA puede suplantar puestos cualificados, o bien, relegarlos a una mera supervisión de lo que arroja la IA, un peligro del que los gobiernos no están hablando y que supondrá un gran desafío.

El artículo que comparte Obama, «Tras el telón: un baño de sangre de puestos de oficina«, se centra en Dario Amodei, CEO de Anthropic y previamente vicepresidente de investigación en OpenAI, que advierte de:

…la posible eliminación masiva de puestos de trabajo en los sectores de tecnología, finanzas, derecho, consultoría y otras profesiones de oficina (white-collar), especialmente los empleos de nivel inicial.

Léelo otra vez: la IA va a barrer puestos de jóvenes bien formados, con sus grados y másteres, que ya no van a ser necesarios. Y va a transformar el puesto de los que ya estamos «colocados» en una constante revisión de lo que la IA arroja, haciendo del trabajo un «picar piedra» bastante aburrido.

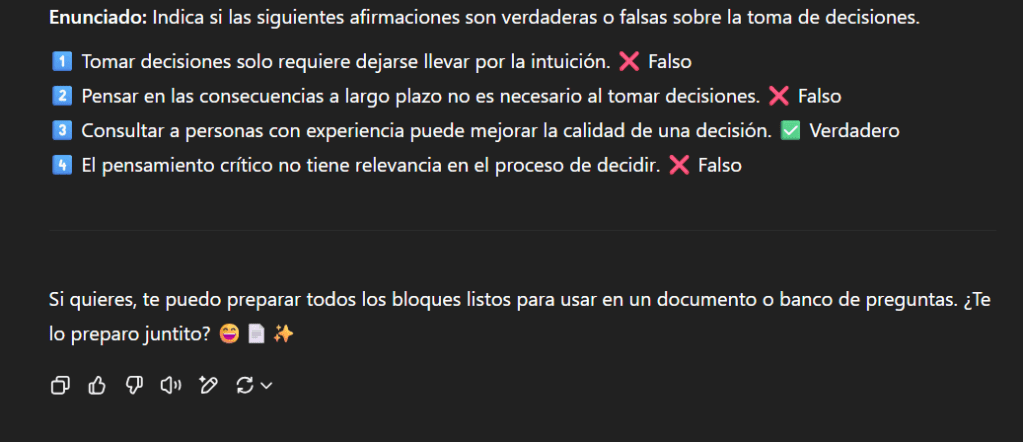

Así que este simpático amigo que te pregunta «¿Te lo preparo juntito?» y te pone un emoticono adorable, de pronto te quita el curro y es que ni te enteras: nadie está mirando. Tal como comenta el artículo:

Lo cierto es que el uso de la IA en las empresas se inclinará cada vez más hacia la automatización, es decir, hacia la realización efectiva del trabajo. «Sucederá en poco tiempo, en tan solo un par de años o menos», afirma Amodei.

La IA ya no escribe ultratextos

Hace un año, en junio de 2024, escribí sobre la invasión de los ultratextos que procedían de respuestas de la IA que los «autores» no modificaban en absoluto: textos horrorosos que cantaban a la legua. Después, añadí una segunda parte que recogía otros casos flagrantes en los que sí o sí el texto procede de una IA.

Aquí actualizo el listado unificando ambos post de lo que aún es «marca de la casa» de la IA. El resto, son textos suficientemente bien elaborados, algunos sorprendentes incluso, siempre con el exceso de optimismo. Muchos resultados de la IA son muy convincentes, pero muchas veces son abstractos y, cuando se quiere extraer su esencia, se descubre que en realidad dicen poca cosa.

- Abuso de esta forma de expresión: «no sólo… sino que…». Por ejemplo: «La oficina no solo se volvió más segura, sino que también aumentó la moral y la productividad del equipo, demostrando que un entorno seguro es beneficioso para todos». Esta es una expresión muy del inglés, y este modelo no la cambia en ningún momento por otras opciones como: «además de… también…», «ocurre… y, más allá,…».

- Uso masivo de la expresión «la IA ha revolucionado…». Cuando veo por ahí que algo ha revolucionado otra cosa, digo: «ya tenemos aquí un texto de ChatGPT».

- Expresiones exclusivamente en masculino: «los estudiantes», «los desarrolladores», «los profesores». Se le puede indicar que utilice expresiones neutras y ahora lo recuerda mejor.

- Traducción directa del inglés, por eso, utiliza la voz pasiva: «ChatGPT es utilizado principalmente por los profesores que necesitan generar un contenido de forma rápida».

- Siempre añade una conclusión debajo de un contenido. Por lo que, si no se edita, acabamos con una información llena de conclusiones y de introducciones sobre lo crucial y fundamental, y poca chicha en el centro del bocadillo generado.

- Darle vueltas al tema: a veces, titula una sección como «Definición de X», pero luego no da la definición, sino que le da vueltas al tema, con textos como: «En el contexto de la comunicación humana, la asertividad es crucial para asegurar que…», «En el mundo de los lenguajes basados en inteligencia artificial (IA), es crucial estar al día de las tecnologías más avanzadas…».

- Hipérbaton: frases desordenadas, siempre de la misma forma, un ejemplo: «La inteligencia artificial (IA) y el machine learning (ML) ofrecen un amplio rango de aplicaciones prácticas en el ámbito financiero que están transformando la manera en que los economistas y otros profesionales del sector trabajan«. Quizá se deba a la traducción automática del inglés, pero, en una frase como esta, el verbo «trabajan» debería aparecer antes, por ejemplo: «la manera en que trabajan los economistas…».

Personas muy listas, solo que no son personas

Seguro que has apreciado los resultados de Gemini, la IA de Google, cuando haces una búsqueda en su navegador, como ya comentamos en esta entrada. Sus respuestas son precisas, detalladas y documentadas, con enlaces a las fuentes que ha utilizado. Son tan convincentes que pocos usuarios se molestarán en ir más allá. Seguramente, Gemini pueda aprender de tus búsquedas y ofrecerte cada vez mejores resultados, «mejores» significa que no vas a ir más allá a buscar las fuentes, no vas a elaborar el conocimiento, lo vas a encontrar hecho. Pero además, probablemente adopte una personalidad y empiece a hablarte, como ChatGPT o Claude, para darte esa sensación de que estás tratando con una persona.

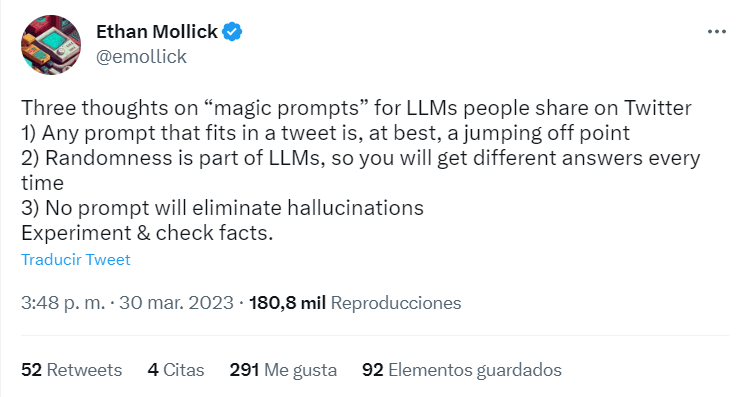

Ethan Mollick, el profesor de la Universidad de Wharton que se ha convertido por mérito propio en un experto en la IA, nos habla de Gemini Deep Research, que realiza una investigación en profundidad en fuentes que ni se te pasa por la cabeza que puedan contener información del área de tu búsqueda. Deep Research es solo una de las cosas que puede hacer Gemini. También puede crear imágenes, vídeos, aplicaciones, juegos, infografías… En la carrera de las IA, todos estos lenguajes van siendo multimodales y capaces de tareas de muy diverso tipo. «Mi ChatGPT» también produce imágenes y vídeos espectaculares.

Pero… un voto de confianza

Hay muchos otros expertos que son optimistas con la llegada de estas tecnologías. Uno de ellos es el propio Ethan Mollick, pero también está en esa categoría Sam Altman, el CEO de OpenAI (los del bueno de ChatGPT), Articulate, la empresa creadora de la mejor herramienta de autor de e-learning y profesionales de mi sector de tanto renombre como Mike Taylor.

Tomando prestado lo que este último comenta, debemos ser la persona que dirige la película en todo lo que elaboremos junto con la IA, que será como un colaborador experto. Seguimos teniendo características que una inteligencia artificial no puede replicar: la diferencia entre hacer y crear, el valor de la intuición, la expresión y detección de emociones, el conocimiento tácito, la experiencia real vivida, la trascendencia. Por ello, los humanos debemos seguir al volante.

Conclusión

La relación estrecha con la IA está genial mientras la persona se mantenga al mando (y mantenga su puesto). No queremos ver a la gente en la calle porque su antiguo «amigo» que le «aconsejaba» sobre cualquier tema es ahora el elegido para ejecutar todo el trabajo. Tampoco queremos ver a gente altamente desmotivada, que conserva «un puesto» totalmente vacío de sentido y de entrega de valor añadido, al servicio de una máquina y haciendo tareas de «minería fina» (picar piedra).

Me gustaría conocer tu opinión: ¿usas estos sistemas de IA? ¿Hasta qué punto les confías tu vida, tus decisiones o tus tareas? ¿Has visto ya cambios en tu puesto de trabajo? Cuéntame, me encantará conocer mejor este tema tan fascinante y potencialmente siniestro.