ChatGPT se ha comparado muchas veces como un becario muy diligente, pero con el que debes tener paciencia, pues carece de memoria. Incluso dentro de una misma conversación en la que le pediste que utilizase ciertos términos, vuelve a usar los que quiere: «olvida» tus palabras.

Yo he empezado a verlo como un perro fiel: está deseando complacer, pero, muchas veces, no entiende los factores humanos que perfilan tu petición (prompt), de manera que ofrece todo tipo de respuestas que no son adecuadas.

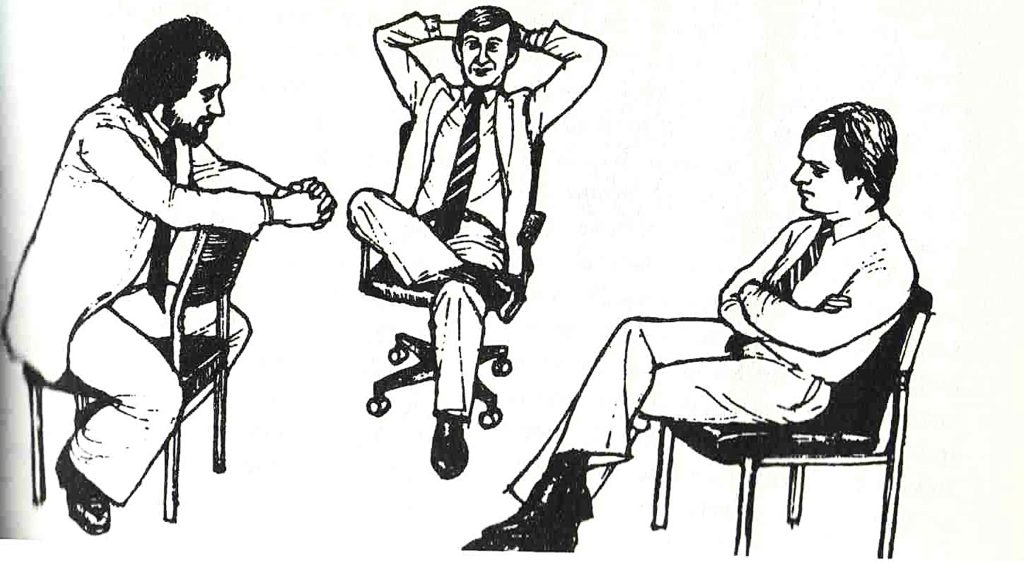

Me lo he pasado realmente bien tratando de que ChatGPT reproduzca una imagen cuya importancia está en las posturas físicas de los personajes. Es esta ilustración de El lenguaje del cuerpo, de Allan Pease:

Pues bien: no hay manera humana de que DALL-E, a partir de ChatGPT 4o, reproduzca las posturas de estos tres hombres. O la hay, pero he tirado la toalla antes de encontrarla.

El más fácil de sacar ha sido el hombre de la derecha: es muy habitual que los modelos posen cruzando manos y piernas. Eso sí, el gesto de hostilidad y cabeza baja no lo he podido reproducir.

El hombre del centro ha costado algo más: fallaba el que no conseguía que tuviera las manos detrás de la cabeza, el gesto clave para determinar que se siente superior a los otros dos, junto con ese acomodarse hacia atrás en la silla con gesto sonriente. Finalmente, tras varios prompts, he logrado esto:

Acabamos por el tío de la izquierda, que trata de controlar la situación sin éxito, al tener la silla volteada y las piernas abiertas, pero los pies juntos por debajo, y sus manos entrelazadas. Ha sido imposible que ChatGPT me ofrezca una imagen de un hombre con los dos pies en el suelo, y ni pensar en que la silla salga al revés, hasta que no le he ofrecido una foto de stock parecida y, aun así, no logro la misma postura, por más que se la describa con detalle. Así que pongo aquí «la conversación» con la que me he reído un rato al comprobar lo «candoroso» que es nuestro becario fiel:

Como puede verse, este hombre no tiene la silla al revés ni la postura del original. Así que yo insisto. Y obtengo lo siguiente:

Le digo a mi becario que está muy bien, pero que ambos pies deben estar en el suelo, a lo que me responde con esto:

Atención a cómo continúa nuestra conversación y cómo, infructuosamente, obtengo señores con la pierna cruzada:

A esta altura, tiré la toalla: ChatGPT no entiende qué es tener los dos pies en el suelo, la silla al revés, o posturas dominantes o sumisas. Al fin y al cabo, no es una persona. Se podría entrenar a un modelo de lenguaje como este a distinguir posturas humanas, esas que cualquiera de nosotros (y un mamífero superior también) reconoce de un solo vistazo. Habría que valorar esta inversión de tiempo en función de las necesidades por las que entrenaríamos al modelo.

La IA es como un socio, no te sustituye

Si la IA comete errores garrafales como ofrecer la imagen de un señor con la pierna cruzada y afirmar con seguridad que los dos pies están en el suelo, piensa que esto puede ocurrir en cualquier otra área de conocimiento. Esto es a lo que nos referimos los usuarios de LLM (estos modelos de lenguaje) cuando decimos que es como hablar a un becario muy diligente, pero sin memoria. Es más, no solo no tiene memoria, sino que «no sabe lo que dice», pero espera «gustar» (y la mayoría de las veces, lo logra).

Cuando trabajas a diario con la IA, como es mi caso, pronto descubres dos cosas: es muy eficiente para algunas tareas y muy ineficiente para otras y siempre requiere de supervisión humana. Ya hemos revisado en este blog qué características tienen los textos que se obtienen con IA y cómo funciona Notebook. Desde mi punto de vista, un modelo de lenguaje como ChatGPT o Notebook puede resultar muy útil para extraer información básica de varias páginas web o de varios documentos, para crear tablas con información, para proponer ideas de forma incansable o para aplicar una explicación teórica a un ejemplo práctico.

Ethan Mollick, el profesor de la Universidad de Wharton que se ha hecho experto en estos lenguajes a base de investigar y utilizarlos concienzudamente (y al que ya hemos citado en otros post), explica 15 formas de utilizar la IA y 5 formas en que no es útil. Entre las formas que son útiles, se encuentran:

- Trabajos que requieren cantidad, como el número de ideas que puede llegar a generar.

- Trabajos en los que eres la persona experta y, por tanto, puedes valorar el grado de acierto del LLM.

- Resúmenes y esquemas de grandes cantidades de información genérica: no esperes precisión.

- Aplicación de una perspectiva a otra, como dar ejemplos de algo en distintos sectores o aplicar un modelo (una rúbrica de evaluación, por ejemplo) a otra temática.

Entre las formas que no son tan útiles, se encuentran:

- La necesidad de aprender algo: no pidas la visión global sobre un tema a un modelo de lenguaje, porque no sabrás si la información es veraz. Incluye tratar de saber sobre temas complejos, o bien, tratar de acortar los pasos que llevan a una comprensión fundamental.

- Cosas en las que la IA no es buena: redactar preguntas de test, encontrar figuras literarias en un texto, distinguir una afirmación falsa de una aparentemente verdadera, etc.

Articulate, mi proveedor principal de herramientas de autor para e-learning y mi cliente, exige en sus condiciones de uso que se señale si existen elementos creados por IA (textos, imágenes, preguntas de test, resúmenes) en los cursos que se crean. Se considera un engaño presentar contenidos creados por IA como hechos por seres humanos. Es algo parecido a plagiar, desde el punto de vista de lo genuino del producto.

Sin embargo, me consta que en diversas organizaciones se hacen pasar contenidos e imágenes generados por IA como hechos por personas. Me pregunto si tales contenidos gozarán de éxito. Personas como Jesús Alonso Gallo o Andrés Pérez Ortega mencionan en sus newsletter no utilizar IA, o bien, haber llegado al desencanto en su uso, porque lo que genera tiene una pinta estupenda, pero, una vez leído, suena hueco, le falta alma.

Recuerda que estos sistemas tienen vocación de perro fiel, buscan gustarte y generar respuestas a las que vas a dar «me gusta», que vas a usar y que te van a hacer volver al sistema a por más.

¿Utilizas IA en tu día a día? ¿Cuál es tu experiencia? Puedes contarme más en comentarios. Muchas gracias por leer y por compartir.

Descubre más desde Desarrollo personal a golpe de texto

Suscríbete y recibe las últimas entradas en tu correo electrónico.

Una respuesta a “El perro fiel”